در دنیای امروز، هوش مصنوعی (AI) به سرعت در حال پیشرفت است و تاثیرات گستردهای در حوزههای مختلف از جمله اقتصاد، علوم، فناوری و زندگی روزمره انسانها دارد. با این حال، این پیشرفتها نگرانیهایی را نیز به همراه داشتهاند. گروهی از دانشمندان برجسته هوش مصنوعی اخیراً با انتشار بیانیهای هشدار دادهاند که اگر کنترل انسان بر روی این فناوری از دست برود، ممکن است پیامدهای فاجعهباری برای بشریت به دنبال داشته باشد. این دانشمندان بر لزوم ایجاد یک سیستم نظارتی جهانی تاکید کردند تا از وقوع چنین نتایجی جلوگیری شود.

بیانیهای از دانشمندان هوش مصنوعی: نیاز به نظارت جهانی بر AI

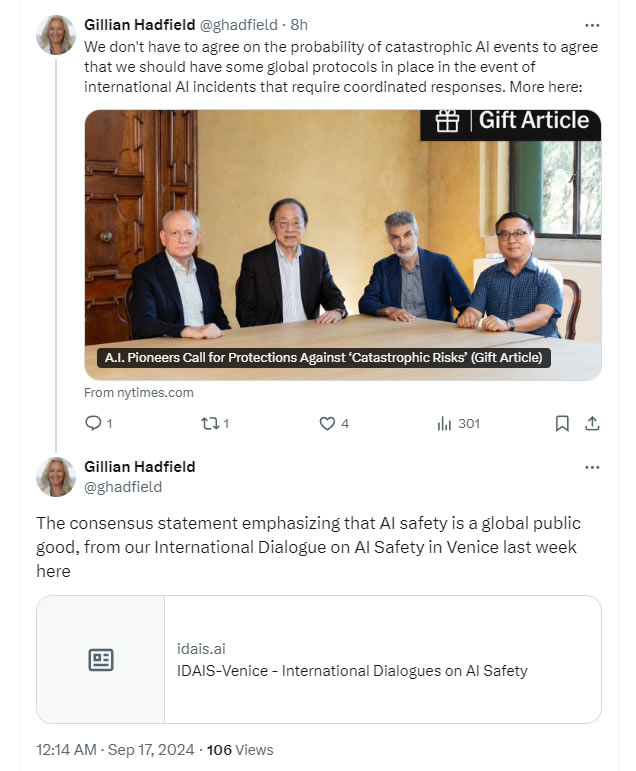

در 16 سپتامبر 2024، گروهی از دانشمندان مطرح حوزه هوش مصنوعی با انتشار بیانیهای نگرانیهای خود را در مورد خطرات احتمالی ناشی از توسعه بیرویه این فناوری اعلام کردند. این گروه که از محققان و دانشمندان برجستهای از کشورهای مختلف مانند ایالات متحده، کانادا، چین، بریتانیا، سنگاپور و سایر کشورها تشکیل شده است، به این موضوع اشاره کردند که اگر انسان کنترل خود را بر روی سیستمهای پیشرفته AI از دست بدهد، ممکن است این فناوری به نتایجی فاجعهبار منجر شود.

در این بیانیه آمده است:

از دست رفتن کنترل انسانی یا استفاده مخرب از این سیستمهای AI میتواند پیامدهای فاجعهباری برای تمام بشریت داشته باشد.» آنها ادامه دادند: «متأسفانه هنوز به علوم لازم برای کنترل و ایمنسازی استفاده از این هوشهای پیشرفته دست نیافتهایم.

درخواست برای ایجاد یک نظام نظارتی جهانی

این دانشمندان توافق کردند که کشورها باید برای تشخیص و پاسخ به حوادث مرتبط با هوش مصنوعی و ارزیابی خطرات فاجعهبار در حوزههای قضایی خود نهادهایی ایجاد کنند. همچنین، نیاز به ایجاد یک «طرح اضطراری جهانی» برای مقابله با شرایط بحرانی ناشی از هوش مصنوعی احساس میشود. این گروه تاکید کرد که در بلندمدت کشورها باید به توسعه یک نظام جهانی برای جلوگیری از توسعه مدلهای هوش مصنوعی که ممکن است به خطرات فاجعهبار جهانی منجر شوند، بپردازند.

این بیانیه به دنبال یافتههایی منتشر شد که در کنفرانس بینالمللی ایمنی هوش مصنوعی در ونیز در اوایل سپتامبر مطرح شد. این کنفرانس که سومین نشست از این نوع بود، توسط گروه تحقیقاتی غیرانتفاعی Safe AI Forum از ایالات متحده برگزار شد.

اهمیت کنترل و آمادگی در برابر تهدیدات هوش مصنوعی

یکی از امضاکنندگان این بیانیه، گلیان هادفیلد، استاد دانشگاه جانز هاپکینز، در پستی که در شبکه اجتماعی X به اشتراک گذاشت، گفت: «اگر شش ماه دیگر با نوعی فاجعه مواجه شویم و تشخیص دهیم که مدلهایی وجود دارند که به طور خودکار بهبود مییابند، از چه کسی کمک میخواهید؟» او این مسئله را به عنوان یکی از بزرگترین چالشها در دنیای امروز مطرح کرد و بر لزوم آمادگی برای مقابله با تهدیدات احتمالی تاکید کرد.

دانشمندان پیشنهاد کردند که ایمنی هوش مصنوعی باید به عنوان یک کالای عمومی جهانی تلقی شود و همکاریهای بینالمللی و نظارت دقیق بر این فناوری ضرورت دارد. آنها سه روند اصلی را برای کنترل و مدیریت هوش مصنوعی پیشنهاد دادند: توافقات و نهادهای آمادهسازی اضطراری، چارچوب اطمینان از ایمنی، و تحقیقات مستقل جهانی در حوزه ایمنی و تأیید هوش مصنوعی.

تلاشهای جهانی برای تنظیم قوانین هوش مصنوعی

در اوایل سپتامبر 2024، ایالات متحده، اتحادیه اروپا و بریتانیا اولین معاهده بینالمللی قانونی مربوط به هوش مصنوعی را امضا کردند که بر حقوق بشر و مسئولیتپذیری در تنظیم مقررات هوش مصنوعی تأکید دارد. این معاهده گام مهمی در جهت ایجاد چارچوبی قانونی برای نظارت بر توسعه و استفاده از هوش مصنوعی است. با این حال، برخی از شرکتهای فناوری و مدیران آنها هشدار دادهاند که تنظیمات بیش از حد میتواند نوآوری را در این حوزه محدود کند، به ویژه در اتحادیه اروپا که مقررات سختگیرانهتری در حال تصویب است.

چالشهای همکاری جهانی

با وجود تلاشهای بینالمللی برای تنظیم قوانین و مقررات مرتبط با هوش مصنوعی، هنوز چالشهای زیادی در این مسیر وجود دارد. یکی از مشکلات اصلی، کاهش تبادل علمی بین قدرتهای بزرگ جهانی مانند ایالات متحده و چین است که منجر به افزایش بیاعتمادی بین این کشورها شده است. این مسئله میتواند دستیابی به توافق جهانی بر سر تهدیدات هوش مصنوعی و راههای مقابله با آن را دشوارتر کند.

دانشمندان هشدار دادهاند که اگر این اختلافات حل نشود و همکاریهای علمی و فناوری میان کشورها تقویت نگردد، ممکن است بشریت با تهدیدات جدیتری مواجه شود. به همین دلیل، گفتگو و همکاریهای بینالمللی در زمینه ایمنی هوش مصنوعی بیش از هر زمان دیگری اهمیت دارد.

دیدگاهتان را بنویسید