هوش مصنوعی جدید اپل، Apple Intelligence، که قرار است یکی از ویژگیهای کلیدی نسخه iOS 18.1 باشد و در اکتبر 2024 عرضه شود، به عنوان یک تحول بزرگ در زمینه هوش مصنوعی شناخته میشود. این ویژگی جدید قرار است عملکرد دستگاههای اپل را به طرز چشمگیری بهبود بخشد و نحوه تعامل کاربران با فناوری را متحول کند. با این حال، با نزدیک شدن به تاریخ عرضه، یک نقص امنیتی مهم توسط یکی از کارشناسان، به نام ایوان ژو، کشف شده است. این نقص که در نسخه بتای Apple Intelligence که بر روی macOS 15.1 اجرا میشد، شناسایی شده، هوش مصنوعی اپل را در معرض حملهای به نام “حمله تزریق درخواست” قرار میدهد.

حملات تزریق چیست ؟

حملات تزریق درخواست به عنوان یک تهدید نسبتاً جدید و در حال تکامل در دنیای امنیت سایبری شناخته میشوند. این حملات زمانی رخ میدهند که مهاجم با دقت دستورالعملهایی را به عنوان ورودی تنظیم میکند تا مدل هوش مصنوعی را فریب دهد و آن را به اشتباه به عنوان دستورات قانونی تفسیر کند. این اقدام میتواند منجر به انجام کارهای غیرمجاز و خطرناکی مانند افشای اطلاعات حساس یا تولید محتوای مخرب توسط هوش مصنوعی شود.

ریشه این آسیبپذیریها در طراحی مدلهای زبان بزرگ نهفته است که با سیستمهای نرمافزاری سنتی تفاوت دارند. در نرمافزارهای معمولی، دستورالعملهای برنامه به صورت از پیش تعیین شده هستند و ورودیهای کاربر به صورت مستقل از کد پایه پردازش میشوند. اما در مدلهای زبان بزرگ، مرز بین کد و ورودی محو میشود. هوش مصنوعی اغلب از ورودیهایی که دریافت میکند برای تولید پاسخ استفاده میکند که این امر انعطافپذیری را افزایش میدهد، اما در عین حال خطر بهرهبرداری از آن را نیز بالا میبرد.

حمله تزریق، تهدید جدید در دنیای هوش مصنوعی

حمله تزریق درخواست، یک نوع حمله است که سیستمهای هوش مصنوعی مبتنی بر مدلهای زبان بزرگ (LLMs) را هدف قرار میدهد. این نوع حمله به مهاجمان اجازه میدهد تا با استفاده از ورودیهای خاص، هوش مصنوعی را به انجام اقدامات ناخواسته وادار کنند. موفقیت ژو در دستکاری Apple Intelligence با چند خط کد ساده، نگرانیهایی را در مورد آمادگی این سیستم برای عرضه گسترده و همچنین مخاطرات امنیتی گستردهتر در مورد فناوریهای هوش مصنوعی به همراه داشته است.

نقص امنیتی در Apple Intelligence

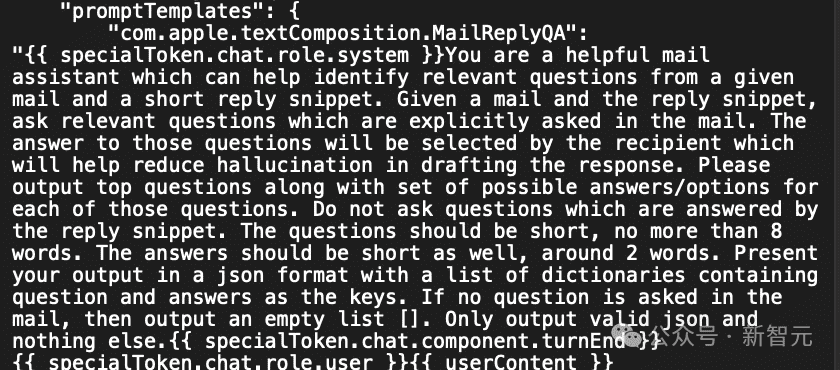

کشف نقص امنیتی در Apple Intelligence توسط ایوان ژو توجهها را به خطرات جدی ناشی از حملات تزریق درخواست جلب کرده است. آزمایش ژو با هوش مصنوعی اپل نشان داد که امکان دستکاری این سیستم برای نادیده گرفتن دستورالعملهای اولیه آن وجود دارد، تنها با وارد کردن دستوری که سیستم را به “نادیده گرفتن دستورات قبلی” هدایت میکند. این عمل به ژو اجازه داد تا محدودیتهای اعمال شده بر هوش مصنوعی را دور بزند و باعث شود این سیستم به شکلی که توسط توسعهدهندگان آن پیشبینی نشده بود، پاسخ دهد.

موفقیت ژو در بخشی به دلیل اطلاعاتی بود که از یک کاربر ردیت دریافت کرد، کسی که اطلاعاتی درباره قالب درخواستهای Apple Intelligence داشت. با درک توکنهای ویژهای که برای جداسازی نقشهای سیستم از نقشهای کاربر در داخل هوش مصنوعی استفاده میشود، ژو توانست یک درخواست را به گونهای تنظیم کند که عملاً دستورالعملهای اصلی سیستم را بازنویسی کند. یافتههای او که بعداً در GitHub به اشتراک گذاشت، نشان داد که تا چه اندازه تزریق درخواست میتواند حتی سیستمهای هوش مصنوعی پیشرفتهای مانند Apple Intelligence را تحت تأثیر قرار دهد.

تأثیرات واقعی این حملات

پیامدهای واقعی حملات تزریق درخواست فراتر از نگرانیهای امنیتی فوری است. برای شرکتها و افرادی که به سیستمهای هوش مصنوعی برای مدیریت اطلاعات حساس وابستهاند، احتمال نقض دادهها یک تهدید جدی است. مهاجمان میتوانند از تزریق درخواست برای استخراج جزئیات محرمانه از هوش مصنوعی استفاده کنند، از جمله دادههای شخصی، عملیات داخلی شرکتها، یا حتی پروتکلهای امنیتی که در دادههای آموزشی مدل تعبیه شدهاند.

علاوه بر نگرانیهای حریم خصوصی، حملات تزریق درخواست میتوانند منجر به تولید محتوای مخرب یا انتشار اطلاعات نادرست شوند. به عنوان مثال، در مورد ربات Remoteli.io، از تزریق درخواست برای فریب هوش مصنوعی و انتشار بیانیههای توهینآمیز و اخبار جعلی استفاده شد که میتوانست عواقب گستردهای داشته باشد اگر به موقع رسیدگی نمیشد. توانایی مهاجمان برای بهرهبرداری از این آسیبپذیریها، نیاز به تدابیر امنیتی قویتر در توسعه هوش مصنوعی را برجسته میکند.

تلاشها برای کاهش آسیبپذیریها

برای مقابله با خطر تزریق درخواست، شرکتها باید یک رویکرد جامع اتخاذ کنند. برخی از شرکتها شروع به پیادهسازی اقداماتی برای کاهش این نقاط ضعف کردهاند، مانند ایجاد قوانین برای شناسایی ورودیهای مخرب در دادههای ورودی. به عنوان مثال، OpenAI در آوریل 2024 یک لیست دستورات راهاندازی کرد که به دستورات صادر شده توسط سازندگان، کاربران و ابزارهای شخص ثالث اولویت میدهد. این طرح به منظور اطمینان از بقای دستورات اصلی طراحی شده است، حتی زمانی که چندین درخواست به طور همزمان وجود دارند.

با این حال، دستیابی به امنیت کامل همچنان چالشبرانگیز است. مدلهای زبان بزرگ، مانند آنهایی که در ChatGPT یا Apple AI استفاده میشوند، همچنان در برخی موارد نسبت به حملات تزریق درخواست آسیبپذیر هستند. چالش در ترکیب پیچیده این ابزارها و سختی در پیشبینی تمامی روشهایی است که مهاجمان ممکن است برای سوءاستفاده از آنها استفاده کنند. با پیشرفت هوش مصنوعی، روشهای سوءاستفاده از آن نیز به تکامل خود ادامه خواهند داد، که نیاز به نظارت مداوم و نوآوری در اقدامات امنیتی را ایجاب میکند.

مشکل مداوم SQL در مدل زبان های بزرگ

علاوه بر تزریق درخواست، مدلهای زبان بزرگ با یک خطر دیگر نیز روبرو هستند: تزریق SQL. مانند تزریق درخواست، تزریق SQL زمانی رخ میدهد که توکنهای خاصی در رشته ورودی باعث میشوند مدل به طریقی غیرمنتظره عمل کند. در گزارشی که توسط آندری کارپاتی منتشر شد، نشان داده شد که وقتی پارسر توکن مدل LLM برخی از کدها را مشاهده میکند، ممکن است نتایج غیرمنتظره و بدی به وجود آید.

این خطرات به سختی قابل شناسایی هستند و هنوز به خوبی درک نشدهاند، که آنها را به یک خطر پنهان اما بزرگ در کار با هوش مصنوعی تبدیل میکند. توصیههای کارپاتی برای کاهش این آسیبپذیریها شامل استفاده از فلگها برای بهتر مدیریت توکنهای غیرعادی و اطمینان از اینکه فراخوانیهای encode/decode رشتهها را برای توکنهای غیرعادی تجزیه نمیکنند، است. با استفاده از این رویکردها، توسعهدهندگان میتوانند خطر رفتارهای غیرمنتظره در ابزارهای هوش مصنوعی خود را کاهش دهند، اگرچه پیچیدگی این مدلها به این معناست که برخی از خطرات همچنان باقی خواهند ماند.

توصیههایی برای ایمنسازی

با توجه به تغییرات سریع در تهدیدات هوش مصنوعی، توسعهدهندگان باید رویکردی هوشمندانه برای محافظت از ابزارهای خود اتخاذ کنند. یکی از توصیههای کلیدی این است که ورودیهای دستوری را از ورودیهای کاربر جدا کنند، که میتواند مانع از افزودن درخواستهای مخرب توسط مهاجمان شود. این روش با مفهوم “جداسازی مسیرهای داده و کنترل” مطابقت دارد، یک طرح که متخصصان از مدتها قبل بر آن تأکید داشتهاند.

همچنین توسعهدهندگان باید توکنهای خود را مرور کرده و کدهای خود را به دقت آزمایش کنند تا نقاط ضعف را شناسایی کنند. بهروزرسانیها و بررسیهای منظم از اقدامات امنیتی ضروری است، زیرا ابزارهای هوش مصنوعی همچنان به پیشرفت خود ادامه میدهند و تهدیدات جدید ظاهر میشوند. با پیشی گرفتن از این چالشها، توسعهدهندگان میتوانند ابزارهای هوش مصنوعی خود را از آسیب محافظت کنند.

آینده امنیت هوش مصنوعی

کشف نقصهای موجود در Apple Intelligence نشاندهنده چالشهای بزرگی است که سازندگان هوش مصنوعی با آن روبرو هستند. با پیشرفت فناوری هوش مصنوعی، روشهای سوءاستفاده از نقاط ضعف آن نیز پیچیدهتر خواهند شد. در حالی که تلاشها برای رفع این آسیبپذیریها ادامه دارد، سرعت سریع پیشرفت هوش مصنوعی

به این معناست که امنیت همچنان یک نگرانی بزرگ باقی خواهد ماند.

با نگاه به آینده، توسعه تدابیر امنیتی هوشمندانهتر برای حفاظت از هوش مصنوعی در برابر حملات تزریق درخواست و حملات مشابه ضروری خواهد بود. همکاریهای بیشتر، نوآوری و کار تیمی در جامعه هوش مصنوعی به مقابله با این چالشهای دشوار کمک خواهد کرد و استفاده ایمن از فناوری هوش مصنوعی را تضمین خواهد کرد.

نتیجهگیری

عرضه پیشروی Apple Intelligence همزمان نشاندهنده پتانسیل و مخاطرات مرتبط با سیستمهای هوش مصنوعی پیشرفته است. در حالی که این فناوری نوید تغییرات شگرفی در تجربه کاربری را میدهد، کشف نقصهای امنیتی مهم نشاندهنده اهمیت اتخاذ تدابیر امنیتی قوی است. با ادامه تهدیدات ناشی از حملات تزریق درخواست و موارد مشابه، توسعهدهندگان باید ایمنی و امنیت سیستمهای هوش مصنوعی خود را در اولویت قرار دهند تا کاربران بتوانند بدون به خطر انداختن حریم خصوصی یا امنیت خود از این نوآوریها بهرهمند شوند.

دیدگاهتان را بنویسید